概要

こんにちわ。

本記事では、先月発表されたMeta社のLlama 3.1 を旧バージョンのモデルLlama 3と性能を比較してみました!

簡単な比較ですが

また、環境構築も一からやりますので、手順の参考になれば幸いです。

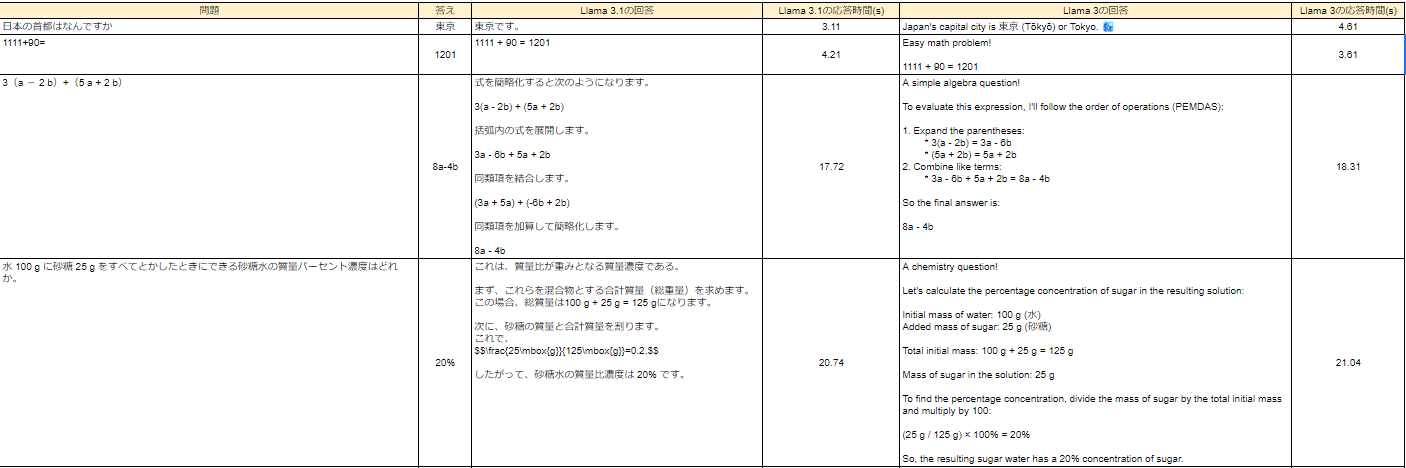

実行結果の比較

まずは結果から。

Llama 3.1 とLlama 3を比較した結果をスプレッドシートにまとめました。

Llama 3.1 の方が若干早く回答あり、自動で日本語での回答になっています。

確かに性能があがっているようです。

※プロンプト送信と同時にストップウォッチを開始

※応答時間は回答がすべて出力されるまでを計測

※両方8Bモデルを使用

同じモデルでも、モデルサイズが3種類あります。(Llama 3.1:8B、70B、405B)

環境構築手順

なんでもいいですが、今回はWindows上のdockerで実行します。

本記事のみでもよいですが、こちらの記事も参考にしてみてください。

1.Ubuntu:20.04の環境を整える

2.Lama 3.1 とLama 3を動作させるためのスクリプトをダウンロード

3.Lama 3.1 、Lama 3を実行!

- 1.Ubuntu:20.04の環境を整える

-

Ubuntu:20.04のダウンロード

docker pull ubuntu:20.04コンテナの作成

docker run -it -d --name コンテナの名前 -p 3000:11434 ubuntu:20.04コンテナの中に入る

docker exec -it コンテナの名前 /bin/bash初期作業としてアップデート・curlコマンドのインストールを実行

apt update apt upgrade apt install curl - 2.Llama 3.1 とLlama 3を動作させるためのスクリプトをダウンロード

-

curl -fsSL https://ollama.com/install.sh | sh - 3.Llama 3.1 、Llama 3を実行!

-

ダウンロードしたプログラムを起動します。

ollama serve -

Llama 3モデルの起動コマンド(初回はダウンロードが実行されます。4.7GB)

ollama run llama3:8bLlama 3.1の起動コマンド(初回はダウンロードが実行されます。4.7GB)

ollama run llama3.1:8b※インストール済みの2回目は、即起動します。

インストールが終わると「send a message」と表示されます。

質問をすると返答が返ってくる状態になります。

管理人の実行環境

OS:Windows11

CPU:AMD Ryzen 5 5600X

メモリー:32GB

GPU:RTX2070 ビデオメモリ:GDDR6 8GB

まとめ

ほんとは70Bモデルで紹介したかったのですが、メモリが足りませんでした。

今後を考えると128GBがあってもいいかも。。。。

405Bに関しては、個人では手が出ないですね。

スパコンやAWSのハイパワーなインスタンスを借りないと困難。

動かしてみたい。。。

ここまで読んでいただきありがとうございました。

おまけ

LLma3.1に歌詞を作らせて、SunoAIで歌にしてみました。